Când am fost la Londra la conferința Big Data LDN, unde am fost speaker, am remarcat într-un interviu că dacă acum un an mai nimeni nu vorbea de algoritmi de AI generativi, precum ChatGPT (pentru text) sau Dall-E, MidJourney (pentru imagine), în acest an subiectul a dominat scena conferinței. Și, fiindcă lumea a început să folosească la greu astfel de algoritmi pentru a scrie email-uri, pentru a scrie propuneri de business, pentru a scrie cod, pentru a genera imagini pentru postări în social media, pentru reclame și chiar pentru video și melodii din spoturi publicitare, merită să explorăm împreună ce riscuri există dacă începi să te joci cu aceste unelte.

În primul rând, vă recomand să citiți articolul Corinei, legat de Impactul inteligenței artificiale în business, pentru a înțelege mai bine beneficiile utilizării inteligenței artificiale în business. Articolul vorbește și despre categoriile principale de AI – îngustă respectiv generală (deocamdată operațională este doar cea îngustă), însă vă invit să descoperiți ramurile operaționale ale inteligenței artificiale, precum machine learning și deep learning.

Machine learning este un subdomeniu al inteligenței artificiale (AI), unde computerele învață din date, în loc să fie programate explicit. Gândiți-vă la acest lucru ca la a învăța computerele să recunoască modele și să ia decizii pe baza acestor modele, așa cum fac oamenii când învață din experiență. Este exact ca atunci când învățați un copil să distingă între pisici și câini. În loc să enumerați fiecare caracteristică posibilă a pisicilor și câinilor, le arătați poze. Cu timpul, copilul învață să-i identifice recunoscând modele. ML funcționează în mod similar, dar cu volume mari de date și algoritmi complecși.

Deep learning este un subset al machine learning, conceput în mod specific pentru a procesa cantități mari de date și a recunoaște modele complexe, adesea folosind structuri numite rețele neuronale, inspirate de creierul uman. Imaginați-vă creierul uman cu miliardele sale de neuroni. Acești neuroni comunică, procesează informații și formează rețele. Deep learning încearcă să replice acest concept digital cu "neuroni artificiali" pentru a procesa date în straturi, permițând recunoașterea unor modele tot mai complexe.

Generative AI este un subset al deep learning ce se referă la algoritmi și modele care au capacitatea de a genera conținut nou. Acest lucru poate fi sub forma de imagini, texte, muzică sau chiar videoclipuri. În loc să analizeze sau să categorizeze doar datele, aceste modele pot crea output-uri complet noi, adesea coerente. Putem compara acest lucru cu artiști care au studiat cantități imense de opere de artă existente și care pe baza lor pot produce noi lucrări care se potrivesc cu stilurile pe care le-au studiat.

Am pus specific aceste trei componente importante, pentru a înțelege mai bine faptul că AI-ul generativ, fiind un subset al deep learning, îi „moștenește” defectul principal: consumă foarte multe resurse. Vom reveni asupra costurilor crescute imediat, mai întâi să vedem ce a dus la „viralizarea” AI-ului generativ și de ce cred eu că înainte de a face pași către „adopția” unui algoritm sau aplicație sau serviciu bazat pe un astfel de algoritm, trebuie să ne facem niște „calcule”.

Bill Schmarzo, autorul cărții AI & Data Literacy: Empowering Citizens of Data Science – carte pe care o recomand oricui, nu doar pasionaților de AI – spune că „AI-ul va face exact ce îl înveți să facă”. Extraordinar de puternică această frază, fiindcă descrie simplu cea mai mare provocare pe care o veți avea cu un AI – procesul de învățare, dezvățare și reînvățare.

Oamenii au o percepție mult prea simplificată despre inteligența artificială, percepție redată și de numeroase filme și întărită de fel de fel de experți, percepție care sună cam în felul următor: „bag date firmei în algoritm și obțin valoare”. Sau, mai aplicat, „bag datele din SAGA în Chat GPT și îl rog (frumos, că oameni suntem) să îmi zică cum să cresc profitul și cum să scad taxele”. Și oamenii se supără când nu primesc răspunsurile corecte sau primesc aberații.

Realitatea diferă însă de percepție. Trebuie să fiți atenți în primul rând la datele folosite pentru training-ul algoritmului: sunt ele calitative, relevante și diversificate? Sunt analizate în contextul în care vor fi folosite? Sunt ele curățate de erori, inconsistențe și valori lipsă? În al doilea rând, înainte de a trece la procesul propriu-zis de training, trebuie să facem pre-procesarea datelor, folosind tehnici precum PCA (Principal Component Analysis) sau LDA (Linear Discriminant Analysis) pentru a reduce dimensiunea și a crește relevanța. După pre-procesare, împărțim setul de date într-unul de training și într-unul de test. Setul de training este folosit apoi pentru procesul de învățare algoritmică. Aici putem alege dintre multe opțiuni, care pentru LLM-uri ar fi Transformer Architecture, Self-Attention Mechanism, Positional Encoding, Layer Normalization & Feed-forward Neural Networks, Gradient-based Optimization și multe altele. Mă opresc aici că deja mă înjurați, așa că sărim la concluzia paragrafului: iarna nu-i ca vara. Pare simplu, băgăm datele într-un Chat GPT, de preferință al nostru și sperăm să iasă bine ce iese. Nu este chiar așa și să vedem de ce...

Nu, nu vom avea un viitor precum cel preconizat în seria Terminator (probabil tot noi vom cauza Apocalipsa, dar despre alta într-un alt episod). Însă există riscuri în utilizarea algoritmilor de AI generativi, precum Chat GPT sau MidJourney. Mă limitez la aceste două exemple deoarece sunt cam cele cunoscute din zona algoritmilor generativi. Și să vedem câteva dintre ele:

ChatGPT minte sau nu? Ați auzit probabil de situația în care un avocat a prezentat într-o instanță americană un caz „inventat” de ChatGPT, pe care avocatul îl credea real. Mulți dintre voi ați ridicat probabil o sprânceană întrebându-vă cum naiba un algoritm ce are acces la internet (indexat până la o anumită dată) poate să scoată o asemenea tâmpenie ce nu există. Un studiu al Universității Stanford a arătat o degradare semnificativă a capabilităților ChatGPT – modelul GPT 4 – de a identifica numere prime; dacă în februarie 2023 rata identificărilor corecte era de 98%, în iunie aceasta era de sub 3%! Nu se știe neapărat ce a dus la această degradare, face parte din magia inteligenței artificiale de tip deep learning, faza pe ignorarea evoluției algoritmului. Însă dacă lumea ar fi citit postarea virală de pe Medium a doamnei Cassie Kozyrkov, data scientist de top, ar fi regăsit următoarea expresie:

"Este ceva foarte important pe care trebuie să-l știți: ChatGPT este produce BS. Esența BS-ului este lipsa de preocupare față de adevăr. Nu este un mincinos, deoarece pentru a fi mincinos, trebuie să cunoști adevărul și să vrei să induci în eroare. ChatGPT este indiferent față de adevăr."

Da, ChatGPT nu a fost gândit ca să spună adevăruri, ci ca să spună „povești”. Da, generează cod, generează text, email-uri, rezumate, eseuri etc., însă ele trebuie verificate atent.

Drept urmare, când produceți conținut cu ChatGPT, verificați de două ori ce iese. S-ar putea să aibă vagi legături cu realitatea.

ChatGPT discriminează? Există o teorie în lumea specialiștilor în protecția datelor, că în momentul în care introduci date personale într-un sistem AI decizional, la un moment dat acesta va discrimina. Logica este legată de faptul că un algoritm AI funcționează foarte mult pe bază statistică, drept urmare va „grupa” rezultate în anumite categorii și va aloca anumite date unor astfel de categorii. AI-ul nu știe de problemele omenirii cu diferențele între rase, între sexe, între orientări sexuale, naționalități, nații, religii etc. Un AI va lua decizii în funcție de ce a învățat (vă amintiți citatul de la începutul articolului?) și de setul de date care i-a fost prezentat. Și aici este foarte, foarte important să fim extrem de precauți: principiile de etică ale omenirii sunt foarte greu de modelat algoritmic, drept urmare algoritmii nu „înțeleg” etica. Iau decizii pe bază de statistică și logică.

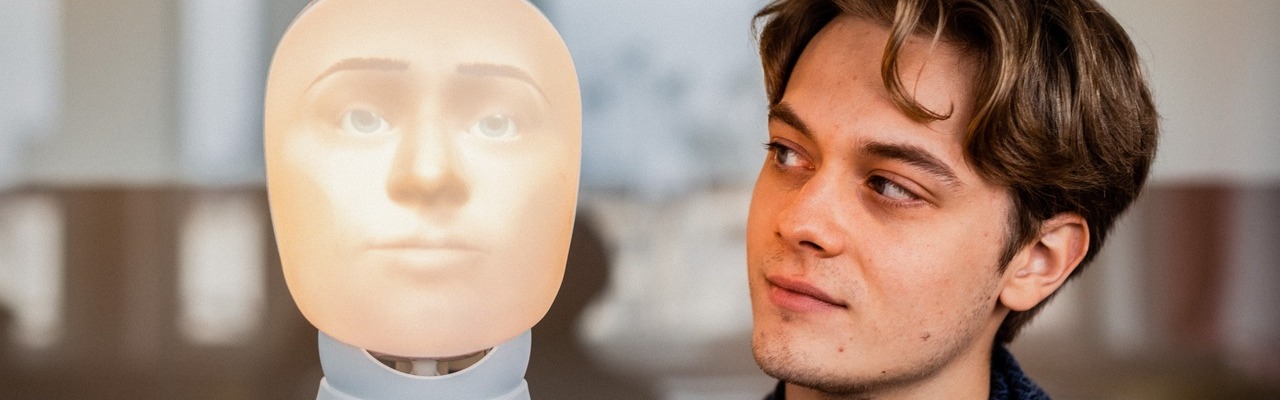

Sunt câteva cazuri celebre aici ce merită explorate. Toate au în comun folosirea algoritmilor de deep learning, familie din care fac parte și algoritmii AI generativi. Un algoritm de recunoaștere facială a rider-ilor Uber nu funcționa corect în cazul persoanelor non-caucaziene. Drept urmare, o parte dintre ei au fost pur și simplu dați afară. Este o problemă a majorității sistemelor de recunoaștere facială care nu sunt neapărat antrenate pe baze de imagini relevante cu persoane de toate etniile, naționalitățile, cu caracteristici faciale diverse etc. Chiar la câțiva clienți de-ai noștri am întâlnit astfel de sisteme ce aveau nevoie să fie din nou antrenate și folosite într-un cadru special de luminozitate. Deci da, dacă folosiți sisteme de recunoaștere facială, s-ar putea să trebuiască să le verificați foarte atent.

Un alt caz celebru a fost la Amazon, unde un algoritm AI de selectare a CV-urilor respingea femeile. Lua sute/mii de CV-uri primite și le alegea pe cele care se potriveau cel mai bine (conform statisticii sale, important de menționat) culturii Amazon. Problema este că algoritmul fusese antrenat pe datele vechilor angajați Amazon, observând informațiile dominante din CV-urile acestora, care erau dominant bărbați. Practic problema fusese la setul de date care nu fusese verificat pentru relevanță și context.

Revenind la ChatGPT: poate acesta discrimina? Păi gândiți-vă că acest algoritm este „antrenat” pe datele publice din multiple surse din Internet, până la o anumită dată. Multe dintre aceste surse conțin factori de discriminare, sunt incorecte, multora le lipsește contextul și așa mai departe. Pe scurt, ChatGPT este antrenat pe date produse de oameni, care sunt pline de prejudecăți uneori. Drept urmare, poate produce rezultate părtinitoare, în ciuda numeroaselor update-uri făcute algoritmului și a diverselor filtre puse la introducerea prompt-urilor. Iar în cazul în care cineva se prinde că a fost discriminat de un algoritm de inteligență artificială, riscați să se ducă la CNCD sau ANSPDCP și să depună plângere. Explorăm perspectiva legală a utilizării algoritmilor de inteligență artificială imediat.

Algoritmii AI generativi copiază? Am vorbit destul despre ChatGPT și algoritmii LLM din familia sa, hai să vorbim și despre algoritmi generativi de imagini. Să revenim puțin la descrierea algoritmilor Gen AI: „artiști care au studiat cantități imense de opere de artă existente și care pe baza lor pot produce noi lucrări care se potrivesc cu stilurile pe care le-au studiat”. Am folosit aici termenul „produce” și nu „creează” fiindcă acești algoritmi nu inovează; ei reproduc chestii învățate pe care le mixează între ele, generând noi lucrări. Și aici este problema: așa cum ChatGPT este „antrenat” pe textele de pe Internet, MidJourney este „antrenat” pe imaginile disponibile public. MidJourney produce lucrări apropiate de cele cu care a fost „antrenat”.

La începutul anului 2023, niște artiști au dat în judecată producătorii algoritmului StableDiffusion (tot Gen AI de imagine) acuzându-i că au permis algoritmului să le indexeze operele fără a le plăti niciun drept de utilizare a operelor. Și Microsoft și GitHub au fost dați în judecată pentru algoritmul CoPilot, ce ajută programatorii să scrie cod. Merită să aruncați un ochi pe evoluția acestor procese fiindcă dacă ele sunt câștigate de inițiatori, va trebui să revizuiți tot ce ați generat cu acești algoritmi generativi. Așa că mai bine revizuiți acum.

Algoritmii generativi AI nu sunt prietenoși cu mediul? Deși trăim în țara în care oamenii aruncă sticlele de plastic direct din mașină (și țigările, și orice altceva îi incomodează în mașină), trebuie să vorbim despre impactul asupra mediului al algoritmilor AI generativi. Cum spuneam la început, acești algoritmi fac parte din familia algoritmilor deep learning și le moștenesc toate defectele. Cel mai mare defect moștenit este necesitatea de utilizare a unor resurse uriașe de calcul, resurse ce necesită foarte multă energie, resurse ce degajează enorm de multă căldură, având un impact asupra mediului ce nu poate fi ignorat.

Cercetătorii de la Universitatea din Massachusetts au publicat un studiu ce arată că procesul de „antrenare” al unui algoritm de deep learning generează aproape 300t de dioxid de carbon. Un alt studiu al Universității din California estimează că Microsoft a consumat aproape 700.000l de apă în procesul de „antrenare” al GPT 3 (nu și 4). Ca să vizualizați mai bine, pentru fiecare 20-50 de prompt-uri în ChatGPT, acesta consumă o sticlă de apă de 500ml.

Probabil că mulți vor ridica din umeri și se vor întreba de ce trebuie să le pese. Păi tot din cauza legilor: Uniunea Europeană a adoptat standardele de raportare europeană a sustenabilității (ESRS), standarde ce se aplică de la 1 Ianuarie 2024. Pe scurt, orice firmă (cu excepția micro-întreprinderilor) trebuie să raporteze impactul pe care îl au asupra mediului. Folosiți algoritmi de inteligență artificială de deep learning? Va trebui să le calculați (și argumentați) impactul pe care îl au asupra mediului!

Am enumerat mai sus câteva riscuri legate de utilizarea acestor algoritmi, respectiv riscul de a genera informații greșite, riscul de discriminare, riscul de încălcare a proprietății intelectuale și riscul de a avea un impact negativ semnificativ asupra mediului. Cum putem adresa aceste riscuri? Hai să identificăm principalele direcții și principalele măsuri tehnice și organizaționale pe care le recomand.

Adevărul nu este interpretabil. Ca să ne asigurăm că AI-ul generativ pe care îl folosim produce rezultate (majoritar) corecte, trebuie să avem controlul asupra sa. Mă îngrozește numărul companiilor ce anunță algoritmi de large-language models similari ChatGPT care însă sunt „wrappers” de ChatGPT, adică apelează ChatGPT pentru rezolvarea prompt-urilor. Este exact ca și cum ai lua o mașină accidentată, ai vopsi-o bine și ai vinde-o ca pe o mașină ce nu a avut niciodată accident. Control înseamnă să ai controlul seturilor de date folosite la training, să poți identifica prejudecățile existente în ele și să le izolezi, să poți face corecțiile output-urilor algoritmului.

Ca să avem controlul asupra algoritmului, cel mai bine este ca acesta să „rezide” în curtea noastră – pe serverele noastre sau în abonamentul nostru de cloud. Astfel, putem controla toți pașii de mai sus și îl putem testa pe scenariile relevante. Da, este mai scump, mai laborios, dar ai controlul rezultatelor și beneficii imediate. Partenerii de la Advisera au dezvoltat un astfel de LLM care să asiste consultanții în livrarea proiectelor de conformitate la ISO 27001, LLM train-uit și hostat intern.

Drept urmare, bugetați-vă algoritmi de AI sau aplicații/ servicii AI pe care să le hostați intern sau în cloud-ul vostru.

Prejudecăți, discriminare, prelucrări de date personale incorecte. Există o carte extraordinară ce ilustrează foarte multe exemple de discriminare în algoritmii de inteligență artificială, Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. În ea sunt descrise cazuri absolut revoltătoare, în care oameni au ajuns să stea nemeritat mai mult în închisori din cauza deciziilor proaste ale unor algoritmi de de deep learning. Ne amintim cu toții de scandalul Cambridge Analytica și de influențarea alegerilor din Statele Unite și a referendumului Brexit din Marea Britanie prin intermediul unor algoritmi avansați de AI de deep learning. Cambridge Analytica a dispărut, practica a rămas. Însă au apărut legile ca să mai calmeze nebunia.

Prima și cea mai cunoscută este GDPR. Din 2018 avem acest regulament european modern de protecție a datelor personale prezent în toate țările membre ale Zonei Economice Europene ce explicit spune la Articolul 22 că există o interdicție generală de a lua decizii asupra indivizilor bazate pe procesarea automată a datelor personale. Există bineînțeles excepții, însă tot regulamentul spune că operatorii de date trebuie să pună în aplicare „măsuri corespunzătoare pentru protejarea drepturilor, libertăților și intereselor legitime ale persoanei vizate, cel puțin dreptul acesteia de a obține intervenție umană din partea operatorului, de a-și exprima punctul de vedere și de a contesta decizia”. La articolele 13 și 14 din GDPR, legate de informarea persoanei vizate, operatorii sunt obligați să-i comunice persoanei vizate despre „existența unui proces decizional automatizat incluzând crearea de profiluri, [...] precum și, cel puțin în cazurile respective, informații pertinente privind logica utilizată și privind importanța și consecințele preconizate ale unei astfel de prelucrări pentru persoana vizată”.

Dacă folosiți un algoritm AI, inclusiv ChatGPT, pentru a evalua aspecte personale ale unui individ, trebuie, conform articolului 35 din GDPR, să faceți o evaluare formală a impactului asupra protecției datelor (un DPIA adică). Atenție, această evaluare este una foarte serioasă și trebuie analizate toate riscurile asupra persoanei vizate.

Pe scurt, dacă băgați date personale (atenție, nu doar nume și prenume, ci orice duce la identificarea unei persoane vizate) într-un algoritm de AI, trebuie să faceți o analiză de risc foarte serioasă, să îi comunicați persoanei vizate acest lucru, să îi explicați cum funcționează algoritmul, cam ce va scoate, cum veți folosi informația, alături de toate celelalte elemente ale informării (atenție că algoritmul s-ar putea să genereze alte date personale). Asta după ce v-ați asigurat că vă încadrați într-o excepție permisă de articolul 22, în cazul în care algoritmul ia decizii.

În al doilea rând, vin legislațiile legate de inteligența artificială. Poate ați auzit de EU AI Act, în curând intră în vigoare. Există o relație foarte strânsă între AI Act și GDPR, pe mai multe paliere:

În cazul în care iar vă gândiți la faptul că din nou birocrații de la Bruxelles pun botniță inovației, vreau să știți că există deja sute de legi la nivel global ce afectează funcționarea algoritmilor de inteligență artificială. Inclusiv în Statele Unite (1, 2) și în China. Conformitatea unui algoritm cu aceste sute de legi va fi o provocare interesantă pentru toți jucătorii, fiindcă nu mai avem abordarea de la protecția datelor personale, unde dacă ești conform cu GDPR ești conform cu 80-90% din legile de protecție a datelor personale din întreaga lume. Și acest lucru este valabil nu doar pentru cei care produc algoritmi de AI (inclusiv GenAI) ci și pentru firmele care utilizează activ algoritmi și sisteme bazate pe algoritmi AI.

Protecția mediului. Din păcate această problemă încă nu este adresată serios la nivel global. Însă având obligații de raportare, va trebui să găsiți soluții să modelați în rapoarte utilizarea algoritmilor AI generativi de la voi din ogradă. Există software-uri dedicate pentru calcularea acestor indicatori de consum, însă toate necesită o analiză obiectivă. Pe care oricum va trebui să o faceți pentru toate operațiunile voastre de business, deci integrarea AI în astfel de modele de calcul nu ar trebui să fie o problemă, odată ce cifrele de consum sunt analizate.

Dacă ați ajuns la capătul articolului, probabil vă întrebați de ce ați investi în utilizarea, dezvoltarea sau implementarea unui sistem de AI generativ gen Chat GPT sau MidJourney. Sunt multe beneficii, descrise în mii de articole, dar aș vrea să mă concentrez pe valoarea educației– urmează să trăim cu astfel de sisteme, că ne place sau nu. Deocamdată utilizarea lor este „ieftină” (abonamentul acela este o bătaie de joc față de costurile reale de consum a acestor tehnologii) și putem învăța cu toții cum să interacționăm cu astfel de sisteme. Dar aveți grijă la impactul utilizării unor astfel de sisteme asupra oamenilor, viețile lor chiar pot fi afectate semnificativ.

Planificați pe termen lung adopția unor sisteme de AI generativ la voi în curte, unde puteți dezvolta propriilor măsuri de control asupra algoritmilor de AI generativ.

Tudor este consultant în protecția datelor având o experiență de peste 20 de ani în business. De șase ani conduce cabinetul de consultanță Tudor Galoș Consulting, lucrând cu o echipă care adresează peste 200 de clienți din Europa, Statele Unite, Marea Britanie și Orientul Mijlociu. Are o certificare europeană de Data Protection Officer obținută la European Center for Privacy and Cybersecurity din cadrul Maastricht University – Faculty of Law, este autorul unui curs DPO acreditat la Ministerul Muncii și Solidarității Sociale și a două cursuri online de GDPR cu peste 15.000 de participanți. Este speaker la evenimente internaționale unde prezintă soluții ce adresează cele mai noi provocări de privacy din domeniile Big Data, Inteligență Artificială, Cloud Computing, Blockchain.

Accesibilitate

Dacă alegi să elimini meniul de accesibilitate, nu îl vei mai putea vizualiza, decât dacă ștergi istoricul de navigare și datele. Ești sigur că dorești să ascunzi interfața?